خطرات هوش مصنوعی در زندگی آینده

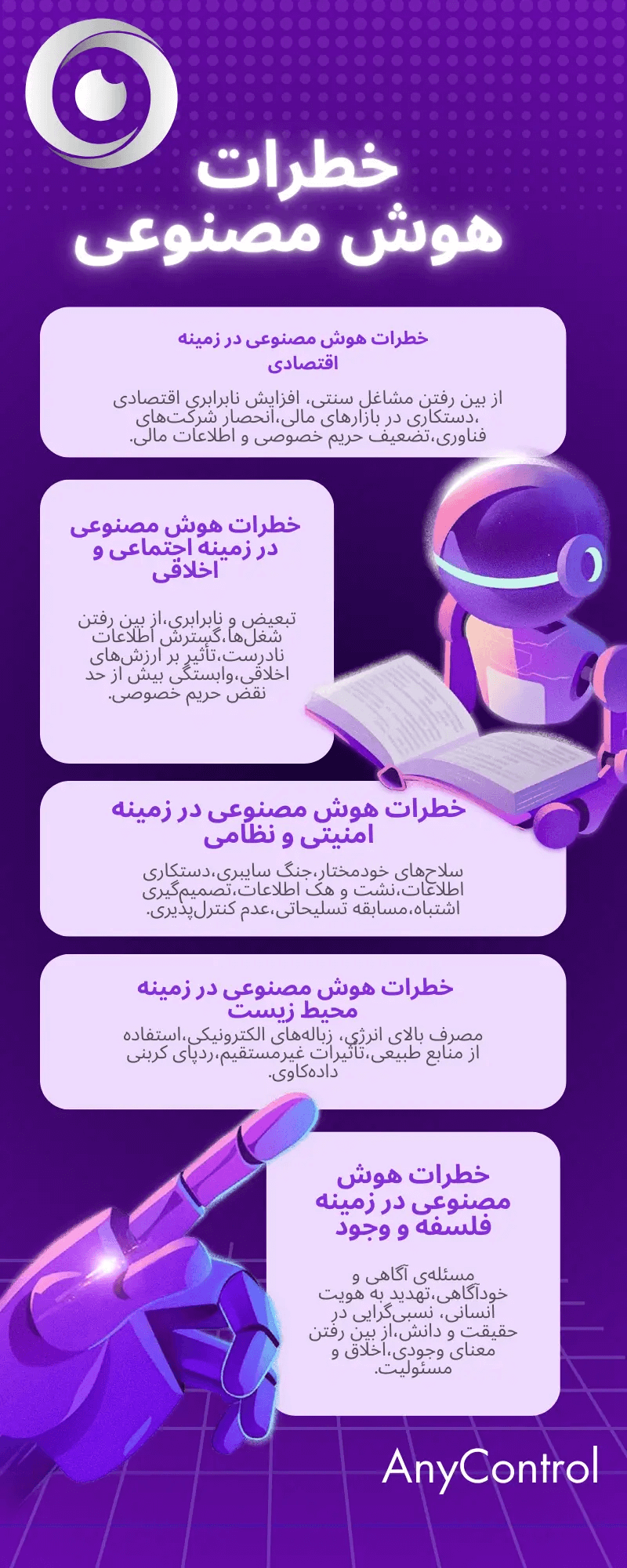

تصور کنید روزی برسد که هوش مصنوعی از انسان ها هوشمند تر شود و به خود حق دهد که کنترل دنیا را در دست بگیرد. این نگرانی دیگر فقط یک داستان علمی تخیلی نیست. چهره های برجستهای مانند جفری هینتون و ایلان ماسک از خطرات جدی این فناوری هشدار داده اند. آیا باید نگران آینده ای باشیم که در آن ماشین ها تصمیم گیرنده اصلی هستند؟ در این مقاله به خطرات هوش مصنوعی و تهدیدات پنهانی که ممکن است در پشت پرده AI وجود داشته باشد خواهیم پرداخت.اگر نگران آینده در دستان هوش مصنوعی هستید از خواندن این مقاله تا انتها غافل نشوید.

آیا هوش مصنوعی حقیقتا خطراتی دارد؟

سؤالاتی در مورد اینکه چه کسی در حال توسعه هوش مصنوعی است و برای چه اهدافی؟ باعث می شود درک نکات احتمالی آن ضروری تر شود. در این مطلب نگاهی دقیق تر به خطرات هوش مصنوعی می اندازیم و چگونگی مدیریت خطرات آن را توضیح میدهیم. این که آیا این افزایش اتوماسیون برخی از مشاغل خاص الگوریتم های مغرضانه و نژادی یا سلاح های خودمختار است که بدون نظارت انسانی کار می کنند. حقیقتا هنوز در مراحل اولیه توسعه هوش مصنوعی هستیم و نمیدانیم که AI چقدر پتانسیل دارد. جامعه فناوری مدت هاست که درباره تهدید های ناشی از هوش مصنوعی بحث کرده است. اتوماسیون مشاغل گسترش اخبار جعلی و یک مسابقه خطرناک تسلیحاتی از سلاح های با قدرت هوش مصنوعی به عنوان برخی از بزرگترین خطرات ناشی از هوش مصنوعی ذکر شده است.

عدم شفافیت هوش مصنوعی

درک مدل های هوش مصنوعی حتی برای کسانی که مستقیماً با این فناوری کار می کنند می تواند دشوار باشد. این امر منجر به عدم شفافیت در مورد چگونگی و چرایی AI می شود و عدم توضیح در مورد چگونگی الگوریتم های هوش مصنوعی و اینکه چرا ممکن است تصمیمات مغرضانه یا ناامن بگیرند؛ این نگرانی ها باعث ایجاد سوالاتی شده که هنوز جوابی برای آن وجود ندارد. کارمندان سابق اپن ای آی و Google DeepMind هر دو شرکت را متهم کرده اند که خطرات احتمالی ابزارهای هوش مصنوعی خود را پنهان می کنند. این رازداری عموم مردم را از تهدیدات احتمالی غافل می کند و باعث می شود که قانونگذاران اقدامات پیشگیرانه ای را انجام دهند که اطمینان حاصل شود که AI با مسئولیت پذیری توسعه یافته است.

🤖همچنین بخوانید: دانلود چت جی پی تی برای اندروید و آیفون

از دست دادن شغل

از دست دادن فرصت های شغلی با هوش مصنوعی یک نگرانی مهم است زیرا این فناوری در صنایعی مانند بازاریابی، تولید و مراقبت های بهداشتی اتخاذ می شود. به گفته مک کینزی تا سال 2030 حداکثر 30 درصد از وظایف نیروی کار می توانند به صورت خودکار انجام شوند به گفته گلدمن ساکس حتی 300 میلیون شغل تمام وقت را می توان در اتوماسیون هوش مصنوعی از دست داد. مارتین فورد گفت:

دلیل اینکه ما نرخ بیکاری پایین داریم ولی شامل افراد بیکار یا کسانی که دنبال شغل نیستند عمدتاً این است که مشاغل بخش خدمات با دستمزد پایین توسط این اقتصاد ایجاد شده است ولی فکر نکنم چنین چیزی به دلیل رشد هوش مصنوعی ادامه دار باشد.

هرچه ربات های هوش مصنوعی باهوش تر و دقیق تر شوند همان کارها به نیروی انسانی کمتری نیاز دارند و در حالی که تخمین زده می شود که هوش مصنوعی تا پایان امسال 97 میلیون شغل جدید ایجاد کند، بسیاری از کارمندان مهارت های لازم برای این نقش های فنی را ندارند و اگر شرکت ها نیروی کار خود را آموزش ندهند می توانند عقب بمانند. به گفته فورد:

برخی از مشاغل هستند که مانند اشپزی به استعداد ذاتی و مهارت نیاز دارند و این چیزی نیست که هوش مصنوعی بتواند دست بگیرد و جاگزین نیروی انسانی شود.

همانطور که کریس مسینا استراتژیست فناوری اشاره کرده است:

هوش مصنوعی در حال حاضر تأثیر قابل توجهی در پزشکی دارد. قانون و حسابداری در مرحله بعدی قرار دارد که تحت تاثیر هوش مصنوعی قرار خواهند گرفت. این موضوع کار وکلا را راحت میکند و آنها را از شر خواندن هزاران مطلب خلاص میکند. چرا که برای هوش مصنوعی ترکیب مقالات وجستجو از میان هزاران مورد به راحتی آب خوردن است.

دستکاری اجتماعی

دستکاری اجتماعی همچنین یکی از دیگر خطرات هوش مصنوعی است. این ترس به واقعیت تبدیل شده است زیرا سیاستمداران برای ارتقاء دیدگاه های خود به سیستم عامل ها تکیه می کنند، تیک تاک که تنها یک نمونه از یک بستر رسانه های اجتماعی است که به الگوریتم های هوش مصنوعی متکی است، فید کاربر را با محتوای مربوط به رسانه های قبلی که در این سیستم عامل مشاهده کرده اند پر می کند. این موضوع نگرانی هایی را در مورد توانایی تیک تاک در محافظت از کاربران خود در برابر اطلاعات گمراه کننده ایجاد می کند. رسانه ها و اخبار آنلاین با توجه به تصاویر و فیلم های تولید شده توسط AI ، تغییر صدای هوش مصنوعی و همچنین دستکاری عمیق در حوزه های سیاسی و اجتماعی حتی حیرت انگیز تر شده اند. این فناوری ها ایجاد عکس های واقع بینانه، فیلم ها، کلیپ های صوتی یا جایگزینی تصویر یک شکل با دیگری در یک تصویر یا فیلم موجود را آسان می کنند. در نتیجه راه دیگری برای به اشتراک گذاشتن اطلاعات غلط و تبلیغات ایجاد شده است که به نفع افراد سودجو است و در آن تمایز بین اخبار معتبر و غلط تقریباً غیرممکن است. فورد گفت:

هیچ کس نمی داند چه چیزی واقعی است و چه چیزی نیست.شما به معنای واقعی کلمه نمی توانید آنچه میبینید و میشنوید را باور کنید.

نظارت اجتماعی ناعادلانه

علاوه بر تهدید وجودی خود فورد بر نحوه تأثیر منفی بر حریم خصوصی و امنیت متمرکز است. نمونه بارز استفاده از فناوری تشخیص چهره چین در دفاتر، مدارس و سایر مکان ها است. علاوه بر ردیابی حرکات شخص، دولت چین ممکن است بتواند داده های کافی را برای نظارت بر فعالیت ها، روابط و دیدگاه های سیاسی شخص جمع کند. مثال دیگر ادارات پلیس ایالات متحده است که الگوریتم های پیش بینی پلیس را دارند تا پیش بینی کنند که در کجا جرایم رخ خواهد داد. مشکل این است که این الگوریتم ها تحت تأثیر نرخ دستگیری قرار می گیرند که به طور نامتناسب بر جوامع تأثیر می گذارد. فورد گفت:

رژیم های اقتدارگرا از آن استفاده می کنند ولی سؤال این است این موضوع چقدر روی کشورهای غربی و دموکراسی ها تاثیر میگذارد و چه محدودیتی را بر روی آن قرار می دهند.

کمبود حریم خصوصی داده

طبق یک بررسی مهمترین نگرانی در بین شرکت ها حریم خصوصی و امنیت داده ها است. با توجه به مقادیر زیادی از داده های متمرکز در ابزار های هوش مصنوعی و عدم تنظیم در مورد این اطلاعات ممکن است مشاغل دلیل خوبی برای تردید داشته باشند. سیستم های هوش مصنوعی غالباً داده های شخصی را برای سفارشی کردن تجربیات کاربر یا کمک به آموزش مدل های هوش مصنوعی مورد استفاده خود جمع می کنند (به خصوص اگر ابزار AI رایگان باشد). داده ها حتی ممکن است در هنگام استفاده از سیستم هوش مصنوعی از دیگر کاربران در نظر گرفته نشوند، زیرا یک اشکال که در سال 2023 با chatgpt رخ داده است به برخی از کاربران اجازه داده بود عناوین را از تاریخ چت کاربر فعال دیگر ببینند. در حالی که قوانینی برای محافظت از اطلاعات شخصی در برخی موارد در ایالات متحده وجود دارد هیچ قانون صریح فدرال وجود ندارد که از شهروندان در برابر آسیب های حریم خصوصی داده های ناشی از هوش مصنوعی محافظت کند.

🤖همچنین بخوانید: دانلود نرم افزار هوش مصنوعی دیپ سیک

تعصبات نژادی و سیاسی

اشکال مختلف تعصب هوش مصنوعی نیز مضر است. استاد علوم کامپیوتر پرینستون در گفتگو با نیویورک تایمز گفت:

تعصب هوش مصنوعی فراتر از جنسیت و نژاد است. علاوه بر داده ها و تعصب الگوریتمی، هوش مصنوعی توسط انسان ها توسعه می یابد و انسان ها ذاتاً متعصب هستند.

به گفته یونسکو فقط از 100 هزار زبان جهان برای پاسخگویی استفاده شده است. 90 درصد از مواد آموزش عالی آنلاین توسط اتحادیه اروپا و کشورهای آمریکای شمالی تولید شود و بیشتر داده های آموزش AI را به منابع غربی بیشتر محدود می کند. تجربیات محدود سازندگان هوش مصنوعی ممکن است توضیح دهد که چرا هوش مصنوعی تشخیص گفتار اغلب در درک برخی از لهجه ها ناکام است یا اینکه چرا شرکت ها نتوانسته اند عواقب ایجاد یک شخصیت های تاریخی را جعل هویت کنند. اگر مشاغل و قانون گذاران برای جلوگیری از بازآفرینی تعصبات قدرتمند، مراقبت بیشتری انجام ندهند تعصبات هوش مصنوعی می توانند فراتر از زمینه های شرکت ها گسترش یابند و مسائل اجتماعی مانند تبعیض مسکن را تشدید می کنند.

نابرابری اقتصادی

اگر شرکت ها از تصدیق تعصبات ذاتی در الگوریتم های هوش مصنوعی خودداری کنند ممکن است ابتکارات خود را از طریق استخدام هوش مصنوعی به خطر بیاندازند. این ایده که هوش مصنوعی می تواند صفات یک نامزد انتخاباتی را از طریق تجزیه و تحلیل صورت و صدا اندازه گیری کند هنوز در اثر تعصبات نژادی لکه دار می شود و همان شیوه های استخدام تبعیض آمیز را تولید می کند که مشاغل ادعا می کنند از بین رفته است. گسترش نابرابری اقتصادی و اقتصادی ناشی از از دست دادن شغل ناشی از هوش مصنوعی یکی دیگر از دلایل نگرانی است. کارگرانی که کارهای دستی و تکراری بیشتری را انجام می دهند به دلیل استفاده از هوش مصنوعی حدود 70 درصد کاهش قیمت داشته اند. با این حال افزایش استفاده از AI تولید کننده در حال حاضر بر مشاغل اداری تأثیر می گذارد و طیف گسترده ای از نقش ها را ایجاد می کند که ممکن است نسبت به از دست دادن شغل آسیب پذیرتر باشد.

ضعف اخلاق و حسن نیت

روزنامه نگاران و چهره های سیاسی حتی رهبران مذهبی زنگ خطر احتمالی هوش مصنوعی را به صدا در آوردند. در یک جلسه واتیکان در سال 2023 و در پیام خود برای روز جهانی صلح 2024 پاپ فرانسیس خواستار ایجاد و اتخاذ پیمان بین المللی الزام آور شد که توسعه و استفاده از هوش مصنوعی را تنظیم می کند. پاپ فرانسیس نسبت به توانایی AI در سوءاستفاده هشدار داد و اظهاراتی ایجاد کرد که در نگاه اول قابل قبول به نظر می رسد اما بی اساس هستند. وی تأکید کرد که چگونه این امر می تواند کمپین های اطلاعات در رسانه های ارتباطی دخالت در انتخابات و موارد دیگر را دستکاری کند در نهایت خطر ایجاد درگیری را افزایش می دهد. ظهور سریع ابزار های تولید کننده هوش مصنوعی به این نگرانی ها ماده بیشتری می بخشد. بسیاری از کاربران از این فناوری استفاده کرده اند تا از نوشتن تکالیف یکپارچگی دانشگاهی و خلاقیت را تهدید کنند. به علاوه از هوش مصنوعی می توان برای تعیین اینکه آیا فرد برای شغل وام مسکن کمک های اجتماعی یا پناهندگی سیاسی مناسب است استفاده میشود که ممکن است تبعیض هایی در این مورد اتخاذ شود.

سلاح های خودمختار که توسط AI ساخته شده است

همانطور که اغلب اتفاق می افتد پیشرفت های تکنولوژیکی برای جنگ مورد استفاده قرار گرفته است. وقتی صحبت از هوش مصنوعی می شود برخی مشتاق هستند که قبل از اینکه خیلی دیر شود کاری در مورد آن انجام دهند، در یک نامه آزاد 2016 بیش از 30،000 نفر از جمله AI و محققان روباتیک در برابر سرمایه گذاری در سلاح های خودمختار هوش مصنوعی عقب نشینی کردند. آنها نوشتند:

سوال اصلی امروز بشریت این است که آیا یک جنگ تسهیلاتی با استفاده از هوش مصنوعی آغاز میشود یا AI میتواند از شروع آن جلوگیری کنید. اگر هرگونه قدرت نظامی بزرگ با توسعه سلاح های هوش مصنوعی پیش برود یک جنگ جهانی تسهیلاتی واقعاً اجتناب ناپذیر است و نقطه پایانی این مسیر فناوری آشکار است.

بسیاری از این سلاح های جدید خطرات اساسی را برای غیرنظامیان در زمین ایجاد می کنند اما هنگامی که سلاح های خودمختار در دست اشتباه قرار می گیرند خطر تقویت می شود. هکرها انواع مختلفی از حملات سایبری را تا کنون انجام داده اند.

بحران های مالی

صنعت مالی نسبت به دخالت فناوری هوش مصنوعی در فرایندهای امور مالی و تجارت روزمره پذیرفته شده است. در نتیجه تجارت الگوریتمی می تواند مسئول بحران بزرگ مالی بعدی ما در بازارها باشد. در حالی که الگوریتم های هوش مصنوعی از قضاوت یا احساسات انسانی برخور دار نیستند بنابراین نمیتوانند در بازارهای مالی ترس و طمع و حتی اعتماد انسان را درک کنند. استفاده از این هوش مصنوعی ها و فروش می تواند منجر به نوسانات شدید بازار می شود. این به معنای این نیست که بگوییم هوش مصنوعی چیزی برای ارائه به دنیای مالی ندارد. در حقیقت الگوریتم های هوش مصنوعی می توانند به سرمایه گذاران کمک کنند تا تصمیمات باهوش تر و آگاهانه تری در بازار بگیرند. اما سازمان های مالی باید اطمینان حاصل کنند که الگوریتم های هوش مصنوعی خود را درک می کنند و چگونه این الگوریتم ها تصمیم می گیرند. شرکت ها باید در نظر بگیرند که آیا هوش مصنوعی میتواند از ایجاد ترس در بین سرمایه گذاران و ایجاد هرج و مرج مالی جلوگیری کند یا نه؟

🤖همچنین بخوانید: هوش مصنوعی دیپ سیک چیست؟

از دست دادن نفوذ انسان

عدم اعتماد به نفس در فن آوری هوش مصنوعی می تواند منجر به از بین رفتن نفوذ انسان و عدم عملکرد انسان در برخی از مناطق جامعه شود. به عنوان مثال استفاده از هوش مصنوعی در مراقبت های بهداشتی می تواند منجر به کاهش همدلی و استدلال انسان شود و استفاده از هوش مصنوعی هایی برای جنریت کردن عکس ها یا ایده ها میتواند از خلاقیت انسان و بیان عاطفی آن بکاهد. تعامل با سیستم های AI بیش از حد حتی می تواند باعث کاهش ارتباط همسالان و مهارت های اجتماعی شود. بنابراین در حالی که هوش مصنوعی می تواند برای اتوماسیون کارهای روزانه بسیار مفید باشد در برخی موارد میتوانند منجر به درون گرایی و آنتی سوشال شدن انسان ها هم بشود.

خودآگاهی غیرقابل کنترل

همچنین این نگرانی وجود دارد که هوش مصنوعی آنقدر سریع پیشرفت خواهد کرد که احساساتی شود و فراتر از کنترل انسان احتمالاً به شکلی مخرب عمل کند. گزارش های ادعا شده از این حساسیت قبلاً اتفاق افتاده است با این که یک حساب محبوب از یک مهندس سابق گوگل است که اظهار داشت AI Chatbot Lamda حساسی شده است و دقیقاً مانند یک شخص با او صحبت می کند. از آنجا که نقاط عطف بزرگ بعدی هوش مصنوعی شامل ساخت سیستم هایی با هوش عمومی مصنوعی و در نهایت ویژگی های انسانی مانند گریه کردن و خندیدن است باید از این موضوع ترسید!

افزایش فعالیت جنایی

از آنجا که فناوری هوش مصنوعی در دسترس تر شده است تعداد افرادی که از آن برای فعالیت های جنایی استفاده می کنند افزایش یافته است. هکر ها هم اکنون می توانند تصاویر کودکان را تولید کنند و تعیین موارد واقعی کودک آزاری را برای اجرای قانون دشوار می کند و حتی در مواردی که کودکان از نظر جسمی آسیب نمی رسانند استفاده از چهره کودکان در تصاویر تولید شده توسط AI چالش های جدیدی را برای محافظت از حریم شخصی آنلاین کودکان و ایمنی دیجیتال ارائه می دهد. کلونینگ صوتی نیز به یک مسئله تبدیل شده است که جنایتکاران صداهای تولید شده توسط AI را برای جعل هویت افراد دیگر و مرتکب کلاهبرداری تلفنی اعمال می کنند. این مثالها صرفاً سطح توانایی های هوش مصنوعی را نشان میدهد بنابراین کار برای آژانس های دولتی و ملی سخت تر می شوند و عموم مردم باید از جدیدترین تهدیدات AI آگاه شوند.

بی ثباتی اقتصادی و سیاسی گسترده تر

سرمایه گذاری بیش از حد در یک ماده یا بخش خاص می تواند اقتصادها را در موقعیتی نامطلوب قرار دهد. هوش مصنوعی میتواند به اقتصاد جهانی با راه حل هایی که به سرمایه گذاران میدهد لطمه بزند یا اگر در رویدادهای سیاسی استفاده شود میتواند باعث هرج و مرج شود.

تهدیدهای امنیت سایبری

افراد سودجو و هکر ها می توانند از هوش مصنوعی برای شروع حملات سایبری استفاده کنند. آنها ابزارهای هوش مصنوعی را برای کلون کردن صداها، تولید هویت های جعلی و ایجاد ایمیل های قانع کننده فیشینگ استفاده می کنند همه با هدف کلاهبرداری، هک کردن، سرقت هویت شخص یا به خطر انداختن حریم خصوصی و امنیت آنها و در حالی که سازمانها از پیشرفت های تکنولوژیکی مانند AI استفاده می کنند تنها 24 ٪ از ابتکارات Gen AI تضمین می شوند. این عدم امنیت تهدید به افشای داده ها و مدل های هوش مصنوعی را نقض می کند که متوسط هزینه جهانی آن 4.88 میلیون دلار در سال است.

ضررهای محیط زیستی

هوش مصنوعی به محاسبات فشرده انرژی با ردپای کربن قابل توجهی متکی است. الگوریتم های آموزش در مجموعه داده های بزرگ و مدل های پیچیده در حال اجرا به مقادیر زیادی انرژی نیاز دارند و این امر به افزایش انتشار کربن کمک می کند. یک مطالعه تخمین می زند که آموزش یک مدل پردازش زبان طبیعی بیش از 600000 پوند دی اکسید کربن ساطع می کند. تقریباً 5 برابر میانگین انتشار یک ماشین در طول عمر خود. مصرف آب نگرانی دیگری است. بسیاری از برنامه های هوش مصنوعی در مراکز داده روی سرورها اجرا می شوند که گرمای قابل توجهی ایجاد می کنند و برای خنک کننده به حجم زیادی از آب احتیاج دارند. یک مطالعه نشان داد که آموزش مدل های GPT-3 در مراکز داده ایالات متحده مایکروسافت 5.4 میلیون لیتر آب مصرف می کند و استفاده از 10 تا 50 بندها از تقریباً 500 میلی لیتر استفاده می کند که معادل یک بطری آب استاندارد است.

نقض مالکیت معنوی

هوش مصنوعی تولیدی به یک تقلید از خلاقیت تبدیل شده است و تصاویری را ایجاد می کند که شکل یک هنرمند را ضبط می کند موسیقی که صدای خواننده یا مقاله ها و اشعار شبیه به سبک نویسنده را تکرار می کند. با این حال یک سؤال اساسی مطرح می شود: چه کسی دارای حق چاپ در محتوای تولید شده توسط AI است چه به طور کامل توسط AI ایجاد شود یا با کمک آن ایجاد شود؟ مسائل مربوط به مالکیت معنوی (IP) که مربوط به آثار تولید شده AI است هنوز در حال توسعه است و ابهام پیرامون مالکیت چالش هایی را برای مشاغل ایجاد می کند.

🤖همچنین بخوانید: معرفی هوش مصنوعی QWEN2.5 علی بابا

نحوه کاهش خطرات هوش مصنوعی

هوش مصنوعی هنوز هم مزایای بی شماری دارد مانند سازماندهی داده های بهداشتی و نیرو دادن به اتومبیل های خودران. برای به دست آوردن بیشترین استفاده از این فناوری امیدوارکننده برخی معتقدند که مقررات زیادی لازم است تا جلوی خطرات و تهدیدات آن گرفته شود. هینتون گفت:

یک خطر جدی وجود دارد که سیستم های AI به زودی باهوش تر از انسان ها شوند و این فقط یک مشکل علمی تخیلی نیست. این یک مشکل جدی است که احتمالاً به زودی با آن مواجه خواهیم شد و سیاستمداران باید به این فکر کنند که میخواهند در مورد آن چه کاری انجام دهند.

مقررات حقوقی را تدوین کنید

مقررات هوش مصنوعی برای ده ها کشور مورد توجه اصلی قرار گرفته است و اکنون ایالات متحده و اتحادیه اروپا اقدامات واضح تری برای مدیریت پیشرفت پیشرفت هوش مصنوعی ایجاد می کنند. در حقیقت دفتر علوم و فناوری کاخ سفید (OSTP) لایحه حقوق هوش مصنوعی را در سال 2022 منتشر کرد سندی که برای کمک به راهنمایی برای راهنمایی استفاده و توسعه هوش مصنوعی ارائه شده است. علاوه بر این جو بایدن در سال 2023 دستور اجرایی صادر کرد و به آژانس های فدرال نیاز داشت تا قوانین و دستورالعمل های جدید را برای ایمنی و امنیت هوش مصنوعی تهیه کنند. اگرچه مقررات حقوقی به معنای ممنوعیت برخی از فناوری های هوش مصنوعی است اما مانع از آن نمی شود که جوامع از سرچ در این زمینه استفاده کنند. فورد استدلال می کند که هوش مصنوعی برای کشورهایی که به دنبال نوآوری و ادامه کار با سایر نقاط جهان هستند ضروری است.

شما نحوه استفاده از AI را تنظیم می کنید، اما پیشرفت در فناوری اساسی را حفظ نمی کنید. من فکر می کنم که این اشتباه خطرناکی خواهد بود. ما تصمیم می گیریم که کجا می خواهیم از هوش مصنوعی استفاده کنیم و کجا نمیخواهیم. جایی که قابل قبول است و جایی که نیست و کشورهای مختلف مختارند که هرکاری که میخواهند با هوش مصنوعی انجام دهند.

استانداردها و بحث های AI سازمانی را تعیین کنید

در سطح شرکت اقدامات بسیاری وجود دارد که مشاغل می توانند هنگام ادغام هوش مصنوعی در عملیات خود انجام دهند. سازمان ها می توانند فرآیندهای نظارت بر الگوریتم ها گردآوری داده های با کیفیت بالا و توضیح یافته های الگوریتم های AI را توسعه دهند. رهبران حتی می توانند هوش مصنوعی را به بخشی از فرهنگ شرکت و مباحث معمول تجاری خود تبدیل کنند و استانداردهایی را برای تعیین فن آوری های قابل قبول هوش مصنوعی تعیین کنند.

فناوری را با دیدگاه علوم انسانی راهنمایی کنید

اگرچه وقتی صحبت از جامعه می شود باید فشار بیشتری برای فناوری وجود داشته باشد تا دیدگاه های متنوع علوم انسانی را در آغوش بگیرد. محققان AI دانشگاه استنفورد این استدلال را در یک پست وبلاگ 2019 ایجاد توصیف کردند و خواستار رهبری ملی و جهانی در تنظیم هوش مصنوعی شدند:

سازندگان هوش مصنوعی باید به دنبال بینش، تجربیات و نگرانی های مردم در سراسر قومیت ها، جنسیت ها، فرهنگ ها و گروه های اقتصادی و اجتماعی و همچنین مواردی از زمینه های دیگر، مانند اقتصاد، حقوق، پزشکی، فلسفه، تاریخ، جامعه شناسی و ارتباطات باشند.

تعادل نوآوری با تکنولوژی بالا با تفکر انسان محور روشی ایده آل برای تولید فناوری هوش مصنوعی مسئول و اطمینان از آینده هوش مصنوعی است که برای نسل بعدی امیدوار است. خطرات هوش مصنوعی همیشه باید موضوع بحث و گفتگو باشد، بنابراین رهبران می توانند راه هایی برای استفاده از فناوری برای اهداف نجیب پیدا کنند. فورد گفت:

من فکر می کنم ما می توانیم در مورد همه این خطرات صحبت کنیم و آنها بسیار واقعی هستند. اما هوش مصنوعی همچنین مهمترین ابزار در جعبه ابزار ما برای حل بزرگترین چالش هایی است که ما با آن روبرو هستیم.

آخرین اخبار فناوری، شبکه های اجتماعی و موارد عمومی را در این بخش بخوانید.

آموزش های کاربردی را به صورت گام به گام به همراه راهنمای تصویری در این بخش بیاموزید.

نکات و ترفندهای شبکه های اجتماعی در این بخش به طور منظم برای بهبود تجربه شما هنگام استفاده از این پلتفرم ها پست می شود.

مدیریت کارکنان بخش کلیدی در مدیریت منابع انسانی است. استراتژی های مدیریت کارکنان به سازماندهی عملیات های متعدد اشاره دارد تا این اقدامات به موفقیت شرکت کمک کند. هر آنچه را که باید در مورد نظارت و راهنمایی کارکنان برای کارایی و بهبود عملکرد لازم است بدانید را در بخش مدیریت کارکنان بیاموزید.

با مطالعه مقالات این بخش با ملاحظات امنیتی در فضای آنلاین و کارهایی که نباید در اینترنت انجام دهید آشنا شوید.

با آموزش های گام به گام و راهنمای تصویری، نحوه روت کردن تلفن هوشمند اندرویدی خود را بیاموزید.

به آموزش های منظم و رایگان دسترسی پیدا کنید و شروع به یادگیری یا بهبود مهارت های خود در استفاده از فناوری و شبکه های اجتماعی کنید.

درایورها و برنامه های مورد نیاز جهت روت و تغییر رام گوشی های اندروید و سایر دستگاهها را می توانید از این قسمت دانلود کنید.

در این بخش از جدیدترین روش های کسب درآمد از طریق اینترنت و گوشی موبایل آشنا شوید.

با استفاده از مقالات این بخش از جدیدترین و پرسود ترین ایردراپ های ارز دیجیتال و نحوه دریافت آن ها با خبر شوید.

آموزش نصب و فعالسازی برنامه انی کنترل بر روی دستگاهها با مدلهای مختلف در این بخش قرار دارد